一、Stable Diffusion基础概念:新手必读

1.1 Stable Diffusion是什么?

Stable Diffusion是一种基于潜在扩散模型(Latent Diffusion Model)的AI图像生成技术,由Stability AI开发并开源。它能通过文本描述(提示词)生成高质量的图像,也支持图像到图像的转换、图像修复和风格迁移等功能。

核心优势:

- 完全免费开源:无需支付使用费,可本地部署运行

- 高度可定制:支持模型微调、LoRA训练和插件扩展

- 丰富的社区资源:大量免费模型、插件和教程可供使用

- 隐私保护:本地运行意味着你的数据和创作不会上传到云端

- 性能灵活:可根据电脑配置调整生成质量和速度

1.2 工作原理:了解背后的技术

Stable Diffusion采用潜在扩散模型,通过在低维潜在空间中进行扩散过程来提升生成效率。整个流程受到多个参数影响,包括随机种子、引导系数(CFG)和采样步数等。

图像生成核心步骤:

- 文本编码:CLIP文本编码器将输入的文本提示词转换为向量表示

- 扩散过程:从随机噪声开始,U-Net模型根据文本向量逐步去除噪声

- 图像解码:VAE解码器将去噪后的潜在表示转换为最终的可见图像

二、系统需求与安装部署:搞定环境配置

2.1 硬件需求:检查你的电脑是否满足条件

| 配置级别 | GPU | 显存(VRAM) | 内存(RAM) | 适用场景 |

|---|---|---|---|---|

| 入门级 | NVIDIA GTX 1660 或更高 | 6GB+ | 16GB+ | 基础图像生成,512×512分辨率 |

| 推荐配置 | NVIDIA RTX 3060 或更高 | 8GB+ | 32GB+ | 高质量图像生成,支持ControlNet |

| 高端配置 | NVIDIA RTX 4070/4080/4090 | 12GB+ | 64GB+ | 高分辨率,多批次,LoRA训练 |

注意:NVIDIA显卡性能通常优于AMD显卡(因CUDA优化),低配置可尝试xFormers内存优化、4bit量化模型或CPU模式(极慢)。

2.2 安装Stable Diffusion WebUI:最简单的部署方法

Windows系统

- 准备环境:安装Python 3.10、Git、最新NVIDIA驱动

- 克隆仓库:

1 | git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git |

- 启动:运行

webui-user.bat,首次启动自动下载依赖和模型。

提示:下载依赖和模型过程会可能很慢甚至超时,可以换源(

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple/)或科学(建议)

macOS系统

- 准备环境:通过Homebrew安装Python 3.10、Git、wget、cmake

1 | brew install python@3.10 git wget cmake |

- 克隆仓库:

1 | mkdir -p ~/stable-diffusion |

- 启动:运行

./webui.sh。

Linux系统

- 准备环境:

1 | sudo apt update |

- 安装NVIDIA驱动和CUDA(如需):

1 | sudo apt install nvidia-driver-535 nvidia-cuda-toolkit |

- 克隆和启动:

1 | git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git |

2.3 首次启动配置:优化性能设置

- 访问

http://127.0.0.1:7860,进入“Settings” - 在“Stable Diffusion”勾选“Move VAE and CLIP to RAM when training if possible. Saves VRAM.”节省显存(如果需要,配置高的跳过)

- Apply settings

2.4 模型下载与管理:安装你的第一个模型

模型类型:

- 基础模型(

.ckpt/.safetensors):控制整体风格和质量 - LoRA模型(

.safetensors):微调特定风格或主题 - VAE模型:改善颜色和细节

安装路径:

- 基础模型:

stable-diffusion-webui/models/Stable-diffusion - LoRA模型:

stable-diffusion-webui/models/Lora - VAE模型:

stable-diffusion-webui/models/VAE

安全提示:优先从Civitai、Hugging Face下载.safetensors格式模型,基本所有模型都在上面了。

三、WebUI界面与基本使用:快速掌握核心功能

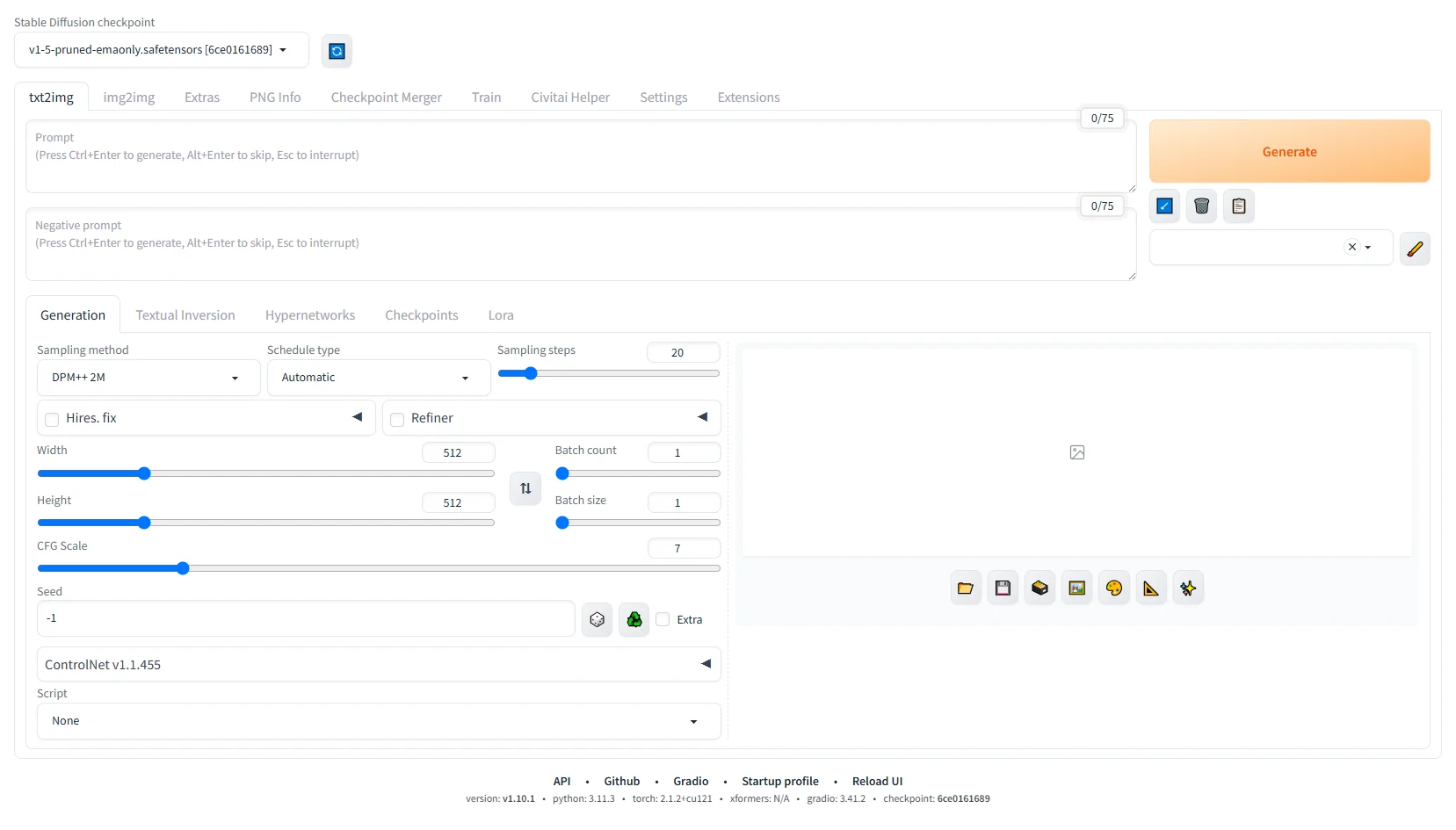

3.1 界面概览

- 顶部选择基础模型:根据不同需求常见选择不同模型

- 导航栏:文生图、图生图、图片扩展、模型合并、训练、扩展管理等

- 左侧参数面板:设置提示词、负面提示词、生成参数

- 右侧图片预览区:显示生成图像和批次结果

- 底部状态栏:显示生成进度和系统状态

3.2 文本生成图像(文生图)

步骤:

- 选择基础模型

- 编写提示词

- 编写负面提示词

- 设置参数:采样方法(推荐DPM++ 2M Karras)、步数(20-30)、CFG Scale(7-9)、尺寸等等

- 点击“生成”。

正向提示词:

1 | #万能画质要求# |

负面提示词:

1 | #避免糟糕人像的# |

提示:提示词有很多网站可以参考,或者插件比如sd-webui-prompt-all-in-one。当然,自己熟悉提示词语法是最佳选择。

展开查看提示词辅助网站

- PromptHero:https://prompthero.com/ ,专注AI绘画提示词,涵盖Stable Diffusion等多种模型,支持风格、主题分类,提供灵感碰撞功能 。

- PromptBase:https://promptbase.com/ ,提示词交易平台,用户可买卖高效提示词,覆盖多领域,有专业资源库 。

- Ai提示词4b3:https://4b3.ai/ ,全方位AI提示词资源平台,涵盖多种模型提示词,支持关键字搜索,有丰富分类和场景模板。

- FlowGPT:https://flowgpt.com/ ,社区驱动的提示词分享平台,涵盖多种工具,有丰富场景和功能模板。

- Lexica:https://lexica.art/ ,以Stable Diffusion为核心的提示词图库,展示生成图片及对应提示词。

- PromptoMANIA:https://promptomania.com/ ,在线提示词生成工具,通过简单操作生成复杂提示词,支持多个AI模型。

- AI Text Prompt Generator:无固定官网(可通过搜索引擎查找在线工具 ),根据输入关键字自动生成相关提示词,适合快速创作。

- finding.art:https://finding.art/ ,可搜索百万AI画作与Prompt,支持Stable - diffusion、midjourney等。

- 魔咒百科词典:https://aitag.top/ ,简单易用的AI绘画tag生成器,可自由选择tag汇集复制 。

- 元素法典——Novel AI元素魔法全收录:https://docs.qq.com/doc/DWHl3am5Zb05QbGVs ,用腾讯文档制作的优质tag生成插图,可直接使用 。

- openart.ai:https://openart.ai/ ,收集大量AI作品和提示词,涵盖各种风格和主题,可作关键词参考库。

采样方法(Sampling method):

采样方法决定了扩散模型如何从噪声中逐步生成图像,不同算法对噪声的处理方式和生成效率不同。

展开查看各种采用方法说明

| 采样方法 | 原理 | 特点 |

|---|---|---|

| DPM++ 2M | 基于扩散概率模型的改进算法,“M”表示多步,通过多步预测精准估计和去除噪声 | 通用性能好,多种画风下可生成高质量图像,细节出色;显存占用高,生成速度相对慢,推荐步数20 - 30步 |

| DPM++ SDE | 基于随机微分方程的采样方法,通过随机过程处理噪声 | 较少步数可得高质量图像,可能出现图像不收敛情况,对人像生成不太友好,易崩图,适合高精度写实类图像生成 |

| DPM++ 2M SDE | 结合DPM++ 2M多步特性与SDE随机过程,在去噪中综合两者优势 | 平衡多步预测和随机噪声处理,能生成高质量图像,显存占用较高,生成速度较慢 |

| DPM++ 2M SDE Heun | 在DPM++ 2M SDE基础上,采用Heun方法(改进的欧拉法)进行数值求解,更准确估计噪声和迭代过程 | 提高采样准确性和稳定性,可生成细节丰富图像,计算量增加,生成速度慢,显存占用高 |

| DPM++ 2S a | “2S”代表二阶单步,“a”表示使用祖先采样,在每个采样步骤向图像添加噪声,属于随机采样 | 采样结果具随机性,图像不收敛,适用于需随机创意效果场景,不适合对图像稳定性要求高的情况 |

| DPM++ 3M SDE | 在DPM++基础上,“3M”表示三阶多步,结合SDE随机过程,通过更复杂多步预测和随机噪声处理迭代图像 | 理论上能更精准处理噪声和生成图像,计算复杂度高,显存占用大,生成速度慢,适合对图像质量要求极高且硬件配置好的情况 |

| Euler a | Euler方法变体,采用祖先采样,在迭代过程中向图像添加噪声 | 显存占用低,生成速度快,适合快速迭代和动漫风格图像生成;易崩图,对提示词精准度要求高,高采样步数时图像不收敛 |

| Euler | 简单的常微分方程求解器,在采样中逐步迭代去噪 | 计算简单,生成速度较快,生成图像相对噪声较多,图像收敛性较好,适用于对速度要求高、对画质要求相对不高的快速预览场景 |

| LMS(Linear Multistep Method) | 线性多步法,通过多个先前步骤信息估计当前步骤噪声和图像状态 | 常生成具有艺术风格图像,在风格化输出方面表现较好,速度与Euler相当,据说准确性更高 |

| Heun | Euler方法的改进版本,通过预估 - 校正步骤更准确求解常微分方程,进行图像去噪迭代 | 比Euler方法更准确,速度较慢,在准确性和生成图像质量上有一定提升 |

| DPM2 | 属于DPM系列的二阶采样方法,通过特定概率模型估计和去除噪声 | 运算速度相对较慢,对tag利用率较高,适合对图像细节和tag应用要求高的场景 |

| DPM2 a | DPM2的变体,结合祖先采样,在去噪过程中引入随机噪声 | 具有一定随机性,对人物有时会有特写效果,收敛性欠佳,运算速度慢 |

| DPM fast | 旨在提高计算效率的DPM采样方法,通过简化或优化计算步骤加快生成速度 | 生成速度快,在图像质量上可能有一定妥协,适合快速生成低要求预览图的场景 |

| DPM adaptive | 自适应步长采样方法,根据图像当前状态动态调整采样步长,优化去噪过程 | 理论上能在不同场景下更灵活生成图像,显存占用极高,生成速度最慢,常用于特殊实验需求,而非日常创作 |

| Restart | 通过重新启动或调整采样过程某些参数,在迭代过程中尝试新路径优化图像生成 | 可在较少步数下生成质量尚可的图像,为图像生成提供新思路,可能对不同模型和提示词适配性有差异 |

| DDIM(Denoising Diffusion Implicit Model) | 通过隐式扩散模型估计和去除噪声,基于固定噪声时间表进行迭代 | 生成图像柔和细腻,在高步数下表现稳定,适合艺术创作(如油画、水彩风格),计算相对耗时,推荐步数30 - 40步 |

| DDIM CFG++ | 在DDIM基础上,对Classifier - Free Guidance机制进行改进优化,通过调整引导强度控制生成图像与提示词的匹配度 | 能更精准根据提示词生成图像,提高图像语义一致性和质量,计算量有所增加 |

| PLMS(Pseudo - Linear Multistep Solver) | 伪线性多步求解器,是DDIM的更新、更快替代方案,利用多步信息更高效估计噪声和迭代图像 | 可在相对较少步数内实现高质量图像生成,在速度和质量上有较好平衡,适合对质量有要求同时希望兼顾效率的场景 |

| UniPC(Unified Predictor - Corrector Framework) | 统一的预测 - 校正框架,通过创新算法框架加速采样过程,在较少步数内完成高质量图像生成 | 收敛速度快,能在10 - 15步左右生成图像,适用于实验性生成和快速预览;与旧模型兼容性可能较差 |

| LCM(Latent Consistency Model) | 基于潜在一致性模型,通过学习潜在空间中的一致性来生成图像,强调生成图像的连贯性和一致性 | 显存占用低,生成速度中等,适合极简设计、扁平化风格图像生成,能避免过度细节化 |

调度类型(Schedule type):

在Stable Diffusion中,Schedule type(调度类型 )负责控制采样过程中每一步的噪声水平,即噪声计划。

展开查看各种调度类型说明

| 调度类型 | 说明 |

|---|---|

| Automatic | 自动模式,系统依据所选采样器自动调用最合适的调度器,一般默认选择,特定模型(如lightning类型模型 )时手动调整可能更佳 |

| Uniform | 均匀调度,以相对均匀方式处理噪声,每一步噪声变化平稳,生成结果具稳定性 |

| Karras | 基于Karras噪声时间表,通过特定数学公式确定噪声变化,生成图像细节和质量好,适合对质量要求高的场景 |

| Exponential | 指数调度,噪声水平按指数规律变化,前期去噪快,后期放缓,先得大致轮廓再细化 |

| Polyexponential | 多指数调度,结合多种指数变化特性,灵活复杂控制噪声,平衡去噪速度和质量,适应不同风格图像生成 |

| SGM Uniform | SGM相关的均匀调度,适用于特定模型(如lightning类型模型 ),使采样高效稳定,生成质量高 |

| KL Optimal | 基于Kullback - Leibler(KL)散度优化,最小化生成分布与目标分布差异,提升图像生成准确性 |

| Align Your Steps | 调整采样步骤与特定模式对齐,确保采样节奏符合预期,使生成结果更可预测、稳定 |

| Simple | 简单调度,采用基础简洁噪声处理方式,计算量小,生成速度快,图像质量可能不如复杂调度精细 |

| Normal | 常规调度,按一般流程控制噪声水平,多数场景提供平衡生成效果 |

| DDIM | Denoising Diffusion Implicit Model专用调度,与DDIM采样算法配合,按固定噪声时间表逐步去噪,生成图像平滑、可预测 |

| Beta | 基于beta噪声时间表,通过调整beta值控制噪声变化,灵活适应不同生成需求 |

采样步数(Sampling steps):

采样步数指模型从纯噪声图像逐步去噪生成最终图像的迭代次数,是影响生成效果的核心参数之一。

作用与影响:

- 质量与细节:

- 步数较少(如 10-20 步):快速生成粗略图像,细节模糊,可能出现噪点或语义偏差。

- 步数较多(如 50-100 步):模型有更多迭代机会优化细节,图像更清晰、连贯,符合提示词的概率更高。

- 注意:超过一定步数后(如 100 步),质量提升可能趋于平缓,计算成本显著增加。

- 风格一致性:

- 步数不足时,模型可能无法充分 “理解” 提示词中的复杂风格(如 “巴洛克”“赛博朋克”),导致风格混杂。

- 步数充足时,模型能更好地捕捉提示词中的风格关键词,生成更贴合预期的图像。

- 计算效率:

- 步数越多,生成速度越慢(尤其是在 CPU 或低性能 GPU 上)。实际应用中需平衡质量与效率,通常推荐20-50 步作为日常生成的合理范围。

3.3 图像生成进阶:批量生成与网格

- 批量生成:设置“批次数量”和“每批数量”,注意显存消耗

- 种子控制:固定种子可复现结果,-1为随机种子

- X/Y图表:批量比较采样器、CFG、步数等参数效果

3.4 图像到图像转换(图生图)

步骤:

- 上传图像,调整“重绘幅度”(0.3-0.5保留细节,0.7-0.9创新)

- 添加提示词描述修改方向

- 点击“生成”。

应用场景:风格转换、内容增强、概念迭代

3.5 局部重绘(Inpainting)

步骤:

- 选择“图生图”→“局部重绘”脚本

- 上传图像并绘制蒙版(白色区域重绘)

- 输入新内容提示词,调整重绘幅度和蒙版模糊

- 生成。

3.6 图像放大与增强

功能:使用R-ESRGAN或SwinIR放大器提升分辨率,支持面部恢复(GFPGAN/CodeFormer)。

3.7 提示词技巧:编写更有效的描述

技巧:

- 权重语法:

(关键词:1.2)增强,[关键词:0.8]减弱 - 结构化提示词:主体→风格→环境→细节→光照

- 修饰词:添加艺术风格(如

oil painting)、质量词(如masterpiece)、技术词(如8k) - 负面提示词:排除

lowres, bad hands, watermark等元素,将最需排除的缺陷词放在负面提示词开头 - 综合:提示词控制在 75 词以内;不同模型对风格词敏感度不同(如AnimeDiffusion更适配二次元风格词),建议先测试基础风格关键词

提示词分类表:

| 类别 | 示例 | 效果 |

|---|---|---|

| 主题描述 | beautiful woman, long blonde hair | 定义核心主体 |

| 场景环境 | forest, sunset, mountain backdrop | 设定背景和场景 |

| 风格触发词 | trending on artstation, concept art | 设定艺术风格 |

| 质量修饰词 | masterpiece, 8k, HDR | 提高图像质量 |

| 光照和氛围 | cinematic lighting, golden hour | 强化照明和氛围 |

四、ControlNet高级功能:精确控制图像生成

ControlNet是Stable Diffusion生态系统中最强大的扩展之一,它允许你通过各种条件输入(如线稿、姿势骨架、深度图等)精确控制图像生成过程。

4.1 ControlNet简介:为什么它如此重要?

传统的Stable Diffusion生成过程主要依赖文本提示词,难以精确控制图像的布局、姿势和结构。ControlNet通过添加额外的条件控制层,使AI能够遵循特定的视觉引导,同时保持高质量的生成效果。

ControlNet的核心优势:

- 精确布局控制:能够让AI严格遵循你设计的构图和结构。

- 多样化条件输入:支持线稿、姿势、深度图、分割图等多种控制模式。

- 保持创意自由:在指定结构的同时,允许AI在细节和风格上发挥创意。

- 提高生成效率:减少随机尝试次数,更快地获得满意结果。

4.2 安装ControlNet:两种方法详解

- 方法一:通过WebUI内置扩展安装(推荐)

在WebUI中打开“扩展”选项卡;选择“从URL安装”子选项卡;输入ControlNet仓库URL:https://github.com/Mikubill/sd-webui-controlnet;点击“安装”按钮;重启WebUI以完成安装。 - 方法二:手动安装(适用于特殊情况)

进入WebUI的扩展目录:cd stable-diffusion-webui/extensions;克隆ControlNet仓库:git clone https://github.com/Mikubill/sd-webui-controlnet.git;下载ControlNet模型:访问Hugging Face的ControlNet模型页面,下载需要的预训练模型(.pth或.safetensors格式),将下载的模型放入stable-diffusion-webui/extensions/sd-webui-controlnet/models目录;重启WebUI激活扩展 。

4.3 ControlNet模型类型:选择适合你需求的模型

ControlNet提供多种预训练模型,每种针对不同类型的控制输入优化:

| 模型类型 | 用途 | 适用场景 |

|---|---|---|

| Canny | 基于边缘检测的控制 | 保留照片的基本轮廓和结构 |

| Depth | 基于深度图的控制 | 保持场景的空间感和立体感 |

| Normal | 基于法线图的控制 | 细致保留3D模型和物体形状 |

| OpenPose | 基于人体姿势的控制 | 精确控制人物的姿势和动作 |

| Lineart | 基于线稿的控制 | 为手绘草图或线稿上色 |

| Scribble | 基于简笔画的控制 | 从简单草图生成完整图像 |

| Seg | 基于分割图的控制 | 控制不同区域的内容分布 |

| SoftEdge | 基于柔和边缘的控制 | 更自然的边缘控制,适合艺术风格 |

建议:初次使用时,可以优先下载Canny、Depth和OpenPose这三个模型,它们最为通用且效果显著。

4.4 使用ControlNet:实用技巧与案例

按照以下步骤使用ControlNet控制图像生成:

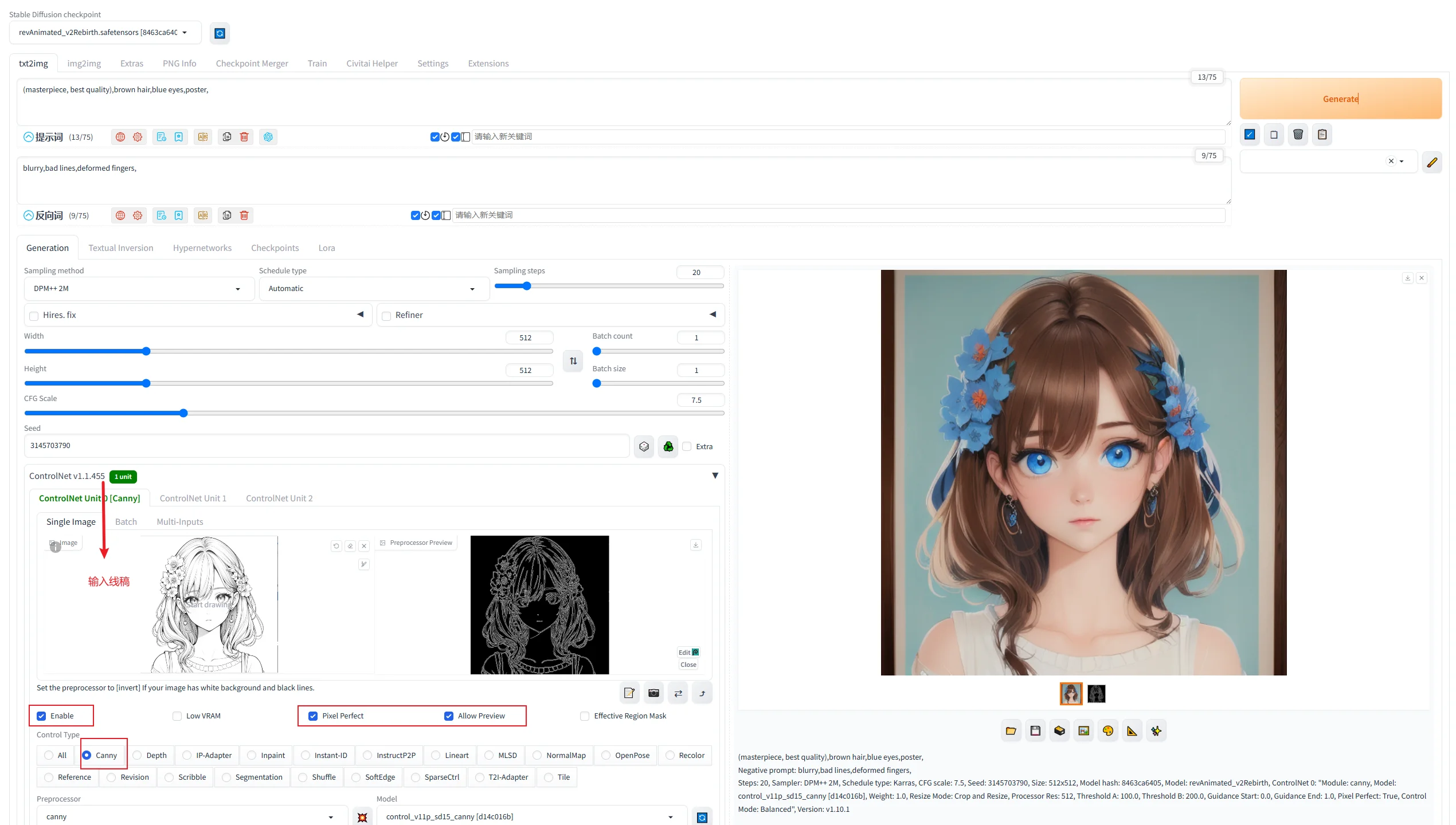

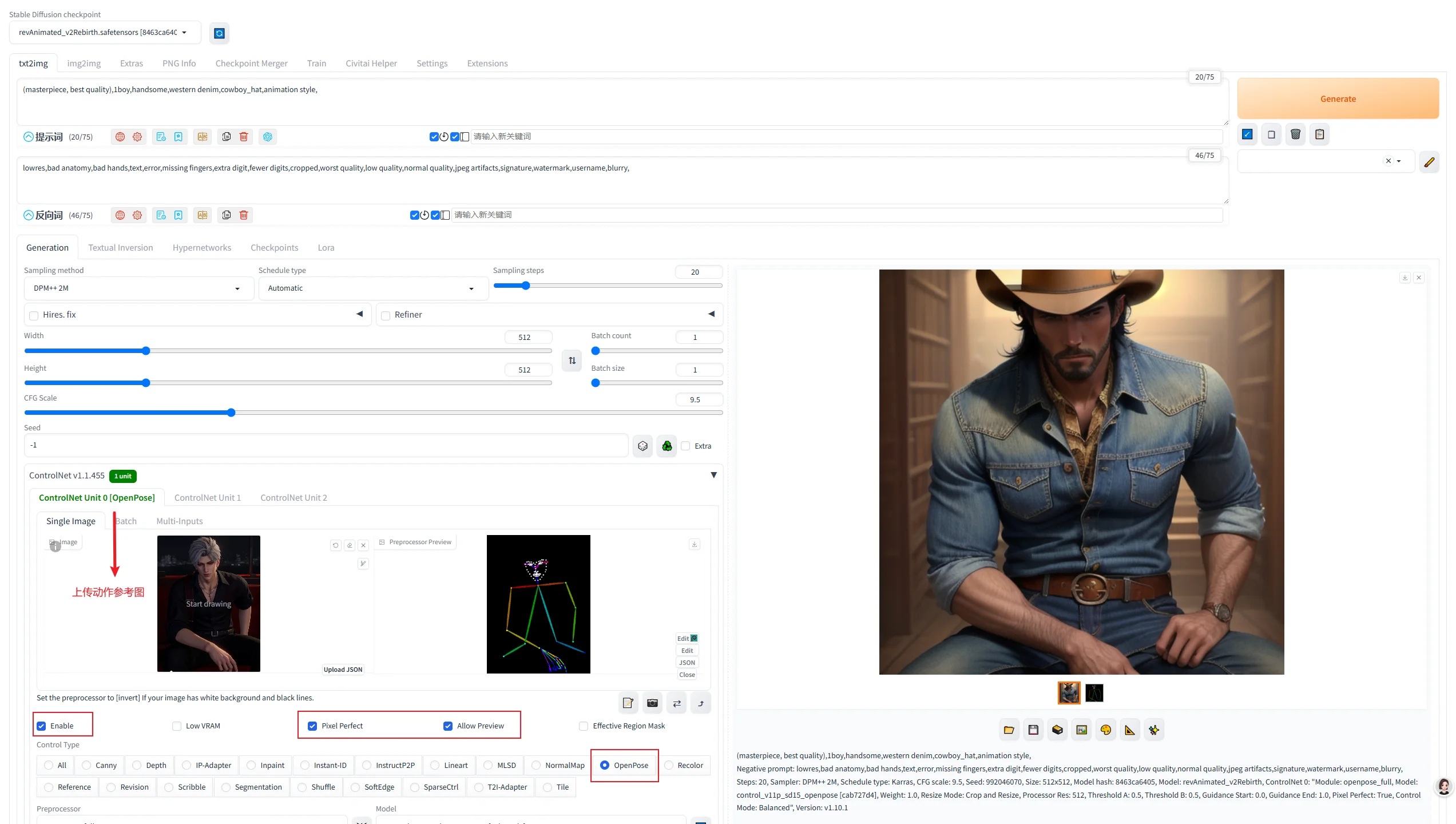

- 准备控制图像:可以上传已有图像(如线稿、照片等),也可以使用内置的预处理器生成控制图(如Canny边缘检测)。

- 配置ControlNet面板:

- 在WebUI中,文生图或图生图界面下方会出现ControlNet面板;

- 勾选“启用”选项激活ControlNet;

- 根据需要调整以下参数:

- 预处理器(选择如何处理输入图像,如Canny、HED等)

- 模型(选择对应的ControlNet模型)

- 控制权重(控制结构一致性的强度,0.5 - 1.0是良好起点)

- 指导开始/结束(控制ControlNet在生成过程中的影响范围 )

- 结合适当的提示词:提示词应与控制图像的内容相协调,专注于描述你想要的风格、细节和氛围。

案例一:使用线稿控制生成精确的角色插画:

- 输入:线稿。

- 提示词:(masterpiece, best quality),brown hair,blue eyes,poster,natural,

- 输出:完成插画。

案例二:使用人体姿势控制生成特定动作的角色:

- 输入:利用参考图的骨架姿势生成新图

- 提示词:(masterpiece, best quality),1boy,handsome,western denim,cowboy_hat,animation style,

- 输出:动作人物。

4.5 多ControlNet协同工作:组合多种控制实现复杂效果

ControlNet的一个强大特性是支持多个控制条件同时工作。通过组合不同类型的控制,可以实现更精确和复杂的图像生成。

- 在WebUI中:

- 打开“ControlNet单元0”、“ControlNet单元1”等多个控制单元

- 为每个单元配置不同类型的控制输入和模型。

- 常见的有效组合:

- Canny + OpenPose:同时控制整体轮廓和人物姿势。

- Depth + Seg:控制空间深度和内容分区。

- Lineart + Normal:结合线稿的细节和法线图的立体感。

多ControlNet使用技巧:

- 为不同控制单元设置不同的权重,优先级较高的控制应设置更高权重。

- 调整每个控制单元的起始/结束比例,避免它们在整个生成过程中相互干扰。

- 对于复杂场景,建议先使用单一控制测试效果,然后逐步添加其他控制。

- 结合参考控制(Reference Control)可以实现风格和内容的双重控制。

4.6 ControlNet创意应用:超越基础用法

除了基本控制外,ControlNet还有许多创新应用:

- 照片改编与风格迁移:使用Canny边缘检测提取照片结构;用艺术风格的提示词生成新图像,保持原始照片的构图和结构,但完全改变风格。

- 从草图到成品的工作流:绘制简单的线稿或草图;使用Lineart或Scribble ControlNet模型;通过提示词指定详细的风格和元素,一键将草图转变为精美插画。

- 3D模型渲染增强:从3D软件导出深度图和法线图;使用Depth和Normal ControlNet模型;生成比传统3D渲染更具艺术感的图像。

ControlNet常见问题解决:

- 问题:生成图像完全忽略控制图。解决方案:增加控制权重或确保使用了正确的模型。

- 问题:图像过于遵循控制图,缺乏创意。解决方案:降低控制权重或调整指导开始/结束值。

- 问题:显存不足错误。解决方案:使用低显存优化选项或减少并发ControlNet数量。

- 问题:预处理器效果不理想。解决方案:尝试手动处理输入图像或调整预处理器参数。

ControlNet是将Stable Diffusion从“随机创意工具”转变为“精准设计工具”的关键扩展。掌握ControlNet将为你的AI艺术创作打开全新的可能性。

五、模型类型与选择指南:找到最适合你需求的模型

Stable Diffusion的生态系统中存在众多不同类型的模型,每种都有其独特的优势和适用场景。

5.1 基础模型类型:了解主要模型分类

Stable Diffusion模型可以按照风格和用途大致分为以下几类:

| 模型类别 | 代表模型 | 特点和优势 | 适用场景 |

|---|---|---|---|

| 写实照片风格 | Realistic Vision, SDXL, Photon | 高度逼真的细节,优秀的光影效果,真实材质表现 | 产品设计,人像摄影,风景写实 |

| 动漫风格 | Anything, Counterfeit, Orange Mixs | 鲜明的二次元风格,角色表现力强,线条清晰 | 动漫插画,角色设计,漫画创作 |

| 艺术绘画风格 | Dreamshaper, Openjourney, Deliberate | 强烈的艺术表现力,丰富的风格多样性,创意性强 | 概念艺术,插画设计,创意表达 |

| 特化模型 | Stable Diffusion XL (SDXL), Stable Video | 针对特定任务优化,高分辨率支持,视频生成 | 专业制作,大尺寸输出,视频创作 |

5.2 模型版本演进:从SD 1.5到SDXL

Stable Diffusion模型经历了几次重要更新,每个版本都带来了显著改进:

- SD 1.4/1.5:第一代广泛使用的模型,训练数据量约50亿图像;512×512分辨率优化,基本的文本理解能力;至今仍有许多优秀的微调模型基于1.5版本。

- SD 2.0/2.1:改进的文本理解能力,使用OpenCLIP作为文本编码器;更好的审美质量,但有时缺乏1.5版本的多样性;768×768分辨率优化。

- SD XL 1.0:大幅提升的图像质量和文本理解能力;1024×1024分辨率优化,更好的构图能力;组合使用两个不同的文本编码器,理解更复杂的提示词;改进的面部和手部渲染。

- 最新专业模型:Stability AI的SDXL Turbo(实时生成能力,1 - 2步出图);Runway的Gen2(生成连贯视频的能力);Midjourney V6(虽不开源但基于SD技术,极高的视觉质量 )。

模型版本选择建议:

- 如果你的GPU显存有限(<8GB),优先考虑SD 1.5基础的模型。

- 如果你主要创作动漫风格内容,1.5版本的特化模型往往表现更好。

- 如果你需要更高的写实度和分辨率,SDXL是更好的选择。

- 对于专业制作,可以尝试SDXL基础上的垂直领域微调模型。

5.3 常见优质模型推荐

以下是经过实测的高质量模型推荐,按照不同风格和用途分类:

- 写实风格模型

- Realistic Vision v6.0:极致的写实效果,出色的人物面部细节;良好的提示词响应度,优秀的光影效果;下载地址:Civitai - Realistic Vision。

- SDXL Reimagined:基于SDXL的写实增强,高分辨率支持;优秀的构图能力,减少畸变现象;下载地址:Hugging Face - SDXL Reimagined。

- 动漫风格模型

- Anything V5:清新的动漫风格,角色表现力丰富;色彩鲜明,线条清晰,适合各类动漫创作;下载地址:Civitai - Anything V5。

- CounterfeitV3.0:高质量二次元风格,精细的细节表现;优秀的手部和面部绘制,服装细节丰富;下载地址:Civitai - CounterfeitV3.0。

- 艺术绘画模型

- Dreamshaper 8:多功能的艺术风格,适应性强;风格多样性,创意表现力,简单提示词也能出好图;下载地址:Civitai - Dreamshaper 8。

- Deliberate v3.0:平衡的艺术表现力,既有创意又有精度;提示词遵循度高,适合精细控制的场景;下载地址:Civitai - Deliberate v3.0。

模型文件格式说明:

.safetensors:更安全的模型格式,无法执行恶意代码,推荐优先使用。.ckpt:传统检查点格式,理论上可以包含可执行代码,有安全风险。.pt/.pth:PyTorch模型格式,通常用于ControlNet等辅助模型。

安全建议:尽可能从知名源下载.safetensors格式的模型,避免潜在安全风险。

5.4 模型混合技术:创建个性化模型

模型混合(Model Merging)是一种强大的技术,允许你组合不同模型的特性,创建个性化的混合模型。

在WebUI中使用模型混合:进入“检查点合并”选项卡;选择2 - 3个要混合的基础模型;设置各自的权重(权重总和应为1);点击“合并”生成新模型。

常见的混合模式:

- 加权平均:最基本的混合方式,按比例混合模型权重。

- Block权重:对不同模块使用不同的混合权重。

- 收藏夹模型添加:允许在生成时动态调整模型组合。

有效的混合策略:

- 混合写实模型与艺术风格模型创建“半写实”效果。

- 混合不同动漫风格模型创建独特的二次元风格。

- 使用专业领域模型微调通用模型的特定能力。

模型混合推荐组合:

- 全能型混合:Realistic Vision (40%) + Dreamshaper (40%) + Anything (20%)。

- enhanced写实:Realistic Vision (70%) + SDXL (30%)。

- 柔和动漫风:Anything (60%) + Counterfeit (40%)。

5.5 VAE与Embedding模型:增强细节与概念

除了主模型外,还有一些辅助模型可以提升生成质量:

- VAE(变分自编码器):VAE负责将潜在空间的表示转换为最终的RGB图像,好的VAE可以显著提升颜色和细节。

- 常用VAE推荐:vae - ft - mse - 840000 - ema(通用VAE,适用于大多数SD 1.x模型);sdxl_vae.safetensors(专为SDXL优化的VAE);Orangemix.vae.pt(适合动漫风格模型的VAE)。

- 使用方法:将VAE文件放入models/VAE文件夹;在设置中的VAE下拉菜单选择对应VAE;或在生成界面的“覆盖设置”中指定VAE。

- Textual Inversion/Embeddings:这些是小型的“概念编码”,教会模型理解特定的风格、角色或物体。

- 使用方式:将.pt或.bin文件放入embeddings文件夹;在提示词中使用特殊标记引用它们,如

<style - name>。 - 常用Embeddings:风格相关(如

<anime - style>,<realistic - photo>);质量相关(如<detail - enhancer>,<better - quality>);概念相关(如特定角色、场景或物体)。

- 使用方式:将.pt或.bin文件放入embeddings文件夹;在提示词中使用特殊标记引用它们,如

5.6 模型管理最佳实践:保持你的模型库有序

随着使用的深入,你可能会收集大量模型。以下是有效管理模型的建议:

- 建立分类系统:按风格分类(写实、动漫、绘画、特效等);按用途分类(人像、风景、角色、概念艺术等);使用前缀命名(如“Real_”, “Anime_”, “Art_”等)。

- 模型元数据管理:使用WebUI的“模型信息”标签查看和编辑模型信息;添加示例图、适用提示词等信息便于参考;记录模型混合的配方和设置。

- 性能优化策略:使用模型剪枝(Model Pruning)减小文件大小;考虑4bit/8bit量化模型降低显存需求;删除很少使用的模型,保持库的精简和高效。

- 备份重要模型:定期备份你最常用和自创的模型;记录模型下载源,以便未来重新获取;使用模型版本控制,保留不同版本的迭代记录。

模型使用注意事项:

- 注意遵循模型许可条款,特别是商业使用限制。

- 一些模型可能含有成人内容倾向,使用时注意适当场合。

- 大型模型需要足够的显存,使用前检查你的硬件是否支持。

- 定期查看模型更新,许多流行模型会发布优化版本。

通过本章节的指南,你应该能够更好地理解不同类型的Stable Diffusion模型,并根据自己的创作需求选择最合适的模型。

六、LoRA训练与自定义模型:创建专属AI艺术风格

LoRA (Low - Rank Adaptation) 是一种轻量级的模型微调技术,让你能够使用少量图像训练出专属的风格、角色或概念。这比完整的模型训练需要更少的资源和时间,是个性化Stable Diffusion的最佳方式。

6.1 什么是LoRA及其优势

LoRA技术的核心优势:

- 资源需求低:只需中等配置GPU,甚至可以在8GB显存的设备上训练。

- 样本需求少:通常只需5 - 20张图像即可获得良好效果。

- 训练时间短:几小时内即可完成训练。

- 体积小巧:通常只有几MB到几十MB,易于分享和存储。

- 可组合性强:可以同时使用多个LoRA,组合不同的风格和特性。

LoRA本质上是在基础模型上添加的“风格补丁”,它只修改原模型的少数关键参数,而不是创建完整的新模型。

6.2 准备LoRA训练环境

要训练LoRA,你需要安装额外的工具。最推荐的方式是使用kohya_ss,这是一个用户友好的LoRA训练界面。

安装kohya_ss(Windows)

下载并安装必要组件:Python 3.10;Git;Visual Studio 2022生成工具(C++桌面开发)。

克隆并安装kohya_ss:

1

2

3git clone https://github.com/bmaltais/kohya_ss.git

cd kohya_ss

.\setup.bat

启动WebUI界面:

.\gui.bat。使用Google Colab训练(免费选项):如果你没有合适的GPU,可以使用Google Colab;搜索“kohya_ss colab”找到最新的Colab笔记本;使用Google账号登录并复制笔记本;按照笔记本中的指示操作。

6.3 准备训练数据集

训练成功的关键在于高质量、一致性强的数据集:

- 收集图像

- 风格LoRA:收集10 - 30张具有一致艺术风格的图像。

- 角色LoRA:收集10 - 20张同一角色的不同姿势图像。

- 概念LoRA:收集5 - 15张表现同一概念的图像。

- 准备图像:

- 确保图像质量高,无水印、文字或模糊区域,大小推荐512×512或768×768

- 保持风格/角色/概念的一致性,避免混合差异过大的样本

- 转换为PNG格式,确保透明背景和清晰度

- 创建标注:

- 为每张图像生成对应的

.txt文本描述文件 - 标注要点:

- 主体特征:如“红发女性、绿色眼睛、华丽盔甲”

- 风格说明:如“digital painting, fantasy style”

- 环境氛围:如“forest background, evening light”

- 可借助自动标注工具(如BLIP、TagAnything)辅助生成,再手动调整

- 为每张图像生成对应的

标注示例:

1 | masterpiece, best quality, digital painting, red haired female, green eyes, fantasy style, detailed face, wearing ornate armor, forest background, evening light |

6.4 LoRA训练流程步骤

使用kohya_ss进行LoRA训练的完整流程:

1. 项目初始化

- 在kohya_ss界面打开“训练”选项卡

- 设置路径:

- 数据集目录:选择包含图像和标注文件的文件夹

- 输出目录:自定义LoRA模型保存路径

- 选择训练类型:推荐使用“Dreambooth LoRA”模式(适合角色/风格微调)

2. 配置基础参数

| 参数名称 | 说明 | 推荐值 |

|---|---|---|

| 基础模型 | 选择训练基于的基础模型(如SD 1.5、SDXL) | 根据风格选择(动漫选SD 1.5,写实选SDXL) |

| 分辨率 | 与数据集图像尺寸一致(通常512×512或768×768) | 512×512(低显存)或768×768(高显存) |

| 批次大小(Batch) | 一次训练处理的图像数量(受显存限制) | 2-8(8GB显存建议设为2-4) |

| 学习率(LR) | 控制模型参数更新速度 | 风格LoRA:3e-4;角色LoRA:1e-4 |

| 训练步数(Steps) | 总训练步数(通常每张图像对应300-500步) | 图像数量×400(如10张图则4000步) |

| LoRA等级(Rank) | 控制模型微调的参数规模(值越大,细节捕捉能力越强) | 风格LoRA:8-12;角色LoRA:16-32 |

3. 高级参数优化

- 正则化提示词(Regularization Prompt):

输入通用描述(如“a photo of a cat”),防止模型过拟合到特定样本

示例:masterpiece, best quality, realistic, professional photography - 学习率衰减(LR Scheduler):

选择“cosine_with_restarts”模式,在训练后期自动降低学习率 - 启用XFormers优化:

勾选以减少显存占用(需提前安装xFormers库)

4. 启动训练与监控

- 点击“开始训练”按钮,界面会实时显示:

- 训练进度(步数/总步数)

- 生成预览图(每500步左右生成一次)

- 损失值曲线(理想状态:损失值平稳下降)

- 中途调整:

- 若预览图出现失真,可暂停训练并调整学习率或正则化提示词

- 建议每1000步保存一次检查点(Checkpoint),便于回滚

5. 训练完成

- 训练结束后,生成的LoRA模型以

.safetensors格式保存至输出目录 - 自动生成

training_metadata.json文件,记录训练参数和标注信息

6.5 使用和分享LoRA模型

1. 在WebUI中加载LoRA

- 安装路径:将LoRA文件放入

stable-diffusion-webui/models/Lora文件夹 - 激活语法:在提示词中添加

<lora:模型名称:强度值>- 强度值范围:0.1-1.0(值越高,LoRA风格越明显)

- 示例:

<lora:fantasy_style:0.7>表示以70%强度应用LoRA

2. 组合多个LoRA

支持同时使用2-3个LoRA,语法:

1

<lora:style_lora:0.6> <lora:character_lora:0.8>

注意事项:

- 风格类LoRA与角色类LoRA组合效果更佳(如“动漫风格+特定角色”)

- 避免超过3个LoRA同时加载,可能导致显存不足

3. 分享与发布

- 平台推荐:Civitai、Hugging Face、Nebula

- 分享内容:

- LoRA模型文件(

.safetensors格式) - 示例图像(展示最佳效果)

- 推荐提示词和基础模型

- 训练数据集规模和参数设置

- LoRA模型文件(

6.6 常见LoRA问题解决

| 问题现象 | 可能原因 | 解决方案 |

|---|---|---|

| 生成图像无LoRA效果 | 强度值过低或模型未正确加载 | 增加强度值至0.5+,检查模型路径是否正确 |

| 图像出现噪点或失真 | 训练步数不足或学习率过高 | 增加训练步数(建议≥3000步),降低学习率至1e-4以下 |

| 角色特征无法保留 | 数据集样本少或标注不精确 | 增加同角色样本至15张以上,标注中强化特征词(如“blue eyes, scar on cheek”) |

| 显存不足导致训练中断 | 批次大小或分辨率过高 | 降低批次大小至2,分辨率设为512×512,启用4bit量化模型 |

| LoRA与基础模型不兼容 | 基础模型版本与训练时不一致 | 确保使用训练时对应的基础模型,或在WebUI中调整“模型兼容性”参数 |

6.7 LoRA训练进阶技巧

- 增量训练(Incremental Training):

对已有LoRA继续训练,添加新风格或特征(需保持数据集一致性) - 权重混合(Weight Merging):

使用WebUI的“模型合并”功能,将LoRA与基础模型合并为独立模型(需谨慎,可能丢失可组合性) - 提示词嵌入(Prompt Embedding):

在训练标注中加入特定触发词(如<my-style>),生成时直接调用触发词激活LoRA

七、常见问题解答与进阶资源

7.1 常见问题解答(FAQ)

Q1:Stable Diffusion完全免费吗?有没有隐藏收费?

- A:核心框架完全开源免费,可本地部署使用。

- 需注意:

- 第三方云服务(如RunwayML、DreamStudio)可能收费

- 部分社区模型的商业使用需遵守许可条款(如CC协议、非商用限制)

- 专业级扩展(如视频生成插件)可能需付费

- 需注意:

Q2:我的电脑配置不足,还能使用Stable Diffusion吗?

- A:可通过以下方式优化:

- 硬件层面:

- 启用4bit/8bit量化模型(如LLaMA系列),显存需求降低50%以上

- 开启xFormers内存优化(WebUI设置中勾选“启用xFormers”)

- 云端方案:

- Google Colab免费版(每日2-3小时GPU时长)

- Kaggle Kernel(提供免费NVIDIA T4 GPU)

- 妥协方案:

- 降低生成分辨率至512×512,关闭抗锯齿和高采样步数

- 硬件层面:

Q3:生成的图像有版权问题吗?可以商用吗?

- A:版权归属需分情况讨论:

- 基础模型生成内容:Stable Diffusion基础模型(如SD 1.5、SDXL)允许商业使用,但需避免侵权提示词(如迪士尼角色、真实人物肖像)。

- 社区模型:需查看具体模型的许可协议(如Civitai模型页通常标注“Commercial Use Allowed”或“Non-Commercial”)。

- 法律建议:涉及品牌设计、人物肖像等场景,建议咨询知识产权律师。

Q4:为什么生成的人物手部总是变形?

- A:手部变形是扩散模型通病,因训练数据中手部标注不足。

- 解决方案:

提示词干预:

1

perfect hands, five fingers, natural pose, detailed fingers

负面提示词排除:

1

malformed hands, extra fingers, fused fingers, missing digits

工具辅助:

- 使用ControlNet的OpenPose模型指定手部姿势

- 局部重绘功能(Inpainting)单独修复手部区域

- 切换至手部优化模型(如Realistic Vision、Meinamix)

- 解决方案:

Q5:如何避免模型下载中的安全风险?

- A:遵循“三优先”原则:

- 优先格式:

.safetensors(无法嵌入恶意代码) - 优先来源:Civitai(人工审核模型)、Hugging Face(官方仓库)

- 优先检查:下载后用防病毒软件扫描,查看模型文件大小是否异常(如正常LoRA约5-50MB,过大可能包含病毒)

- 优先格式:

7.2 进阶学习资源

▍官方与社区资源

- 核心文档

- Stable Diffusion官方文档:涵盖安装、参数解析和API调用

- Hugging Face Diffusers教程:适合开发者深入理解模型原理

- 社区平台

- Reddit社区 r/StableDiffusion:日均数万条讨论,实时跟踪新技巧

- Civitai论坛:模型开发者聚集地,可获取独家训练配方

- Stable Diffusion Discord:官方社群,定期举办技术AMA

▍教程与课程

- 入门到精通系列

- Camenduru的YouTube教程:涵盖LoRA训练、ControlNet高阶应用

- Stable Diffusion官方认证课程:含商业案例实战

- 技术博客

- Stability AI博客:官方技术动态,如SDXL新功能解析

- Medium专题#StableDiffusion:独立开发者经验分享

▍论文与技术报告

- Stable Diffusion原理论文:了解潜在扩散模型的数学基础

- LoRA论文:Low-Rank Adaptation of Large Language Models:掌握轻量级微调核心原理

7.3 推荐扩展和工具

▍WebUI必备扩展

| 扩展名称 | 功能描述 | 安装方式 |

|---|---|---|

| ControlNet | 精确控制图像生成(线稿、姿势、深度图等) | https://github.com/Mikubill/sd-webui-controlnet.git |

| sd-webui-prompt-all-in-one | 提示词自动补全、分类推荐(含艺术风格、灯光效果库) | https://github.com/Physton/sd-webui-prompt-all-in-one.git |

| Stable-Diffusion-Webui-Civitai-Helper | 用于管理 Civitai 模型的扩展工具 | https://github.com/butaixianran/Stable-Diffusion-Webui-Civitai-Helper |

| Image Browser | 图像批量浏览、标签管理、EXIF信息查看 | https://github.com/zanllp/sd-webui-infinite-image-browsing |

▍进阶创作工具

3D辅助工具

- Blender + ComfyUI:通过节点式工作流将3D模型转为ControlNet输入(如深度图、法线图)

- MakeHuman:快速生成人体姿势参考图,导出为OpenPose格式

视频生成工具

- Deforum:基于Stable Diffusion的视频动画插件,支持文本驱动镜头移动

- Stable Video Diffusion:官方视频生成模型,可生成1024×1024分辨率视频片段

生产力工具

- Auto1111-WebUI-Extensions:包含100+实用扩展集合(如批量重绘、提示词翻译)

- W&B(Weights & Biases):训练过程可视化工具,实时监控LoRA训练损失曲线

7.4 社区最佳实践

▍模型管理技巧

文件夹结构示例:

1

2

3

4

5

6

7

8

9

10

11

12stable-diffusion-webui

├─ models

│ ├─ Stable-diffusion

│ │ ├─ Realistic_Vision_v6.safetensors # 写实基础模型

│ │ └─ SDXL_Reimagined.safetensors # 高分辨率模型

│ ├─ Lora

│ │ ├─ anime_style.lora.safetensors # 风格LoRA

│ │ └─ my_character.lora.safetensors # 角色LoRA

│ └─ VAE

│ └─ sdxl_vae.safetensors # SDXL专用VAE

└─ embeddings

└─ style_token.bin # 文本嵌入文件

▍提示词工程工作流

分层构建法:

1

2[主体] + [风格] + [环境] + [技术参数]

例:portrait of a cyberpunk girl, digital art, neon-lit city, 8k, ultra-detailed负面提示词模板:

1

lowres, bad anatomy, text, watermark, signature, blurry, cropped, out of frame

▍性能优化清单

- 显存不足时:

- 启用“Move VAE and CLIP to CPU”(WebUI设置→Stable Diffusion)

- 使用FP16精度训练(kohya_ss高级设置中勾选)

- 关闭抗锯齿(AA)和高分辨率修复(HR)功能

总结与展望

Stable Diffusion的魅力在于其开源生态的无限扩展性——从基础图像生成到ControlNet精确控制,从LoRA个性化训练到多模型混合,每个环节都充满探索空间。未来技术趋势将聚焦于:

- 多模态融合:文本+图像+3D模型的联合生成(如Stable Diffusion 3传闻支持3D场景描述)

- 实时交互:SDXL Turbo已实现1-2步生成,未来或支持视频流级实时编辑

- 低代码开发:节点式界面(如ComfyUI)将成为主流,降低技术门槛