当下 AI 领域最炙手可热的概念,莫过于 MCP。

MCP 指的是 Model Context Protocol(模型上下文协议)。令人意外的是,一个协议系统的热度,甚至盖过了 OpenAI 发布的最新模型,成为行业讨论的焦点。

随着 Manus 的爆火,全球开发者对 Agent 技术的热情空前高涨。MCP 作为 Agent 工具调用的 “统一协议”,短短两个月内即获得了 OpenAI、Google 等主要 AI 公司的支持,从一个边缘技术规范一跃成为 AI 生态的底层标准。

它的崛起速度之快,堪称 AI 基础设施领域的 “现象级事件”。而开发者社区也涌现出各种 MCP 服务,仿佛它已是 AI 工具调用的 “终极答案”。

然而,当最初的狂热稍退,我们不得不面对更复杂的问题:MCP 真的适用于所有场景吗?它是否被赋予了过高的期待?

本文将从 MCP 的起源出发,剖析其核心价值与局限性,澄清常见误解,并探讨它的未来发展方向。我们的目的并非否定 MCP 的价值,而是希望回归理性 —— 只有明确它的实际定位和适用边界,才能真正发挥它的潜力。毕竟,技术史上从不缺少 “神话”,而真正的进步,往往始于祛魅之后的清醒认知。

MCP的本质:统一的工具调用协议

什么是 MCP?

MCP 是一种开放的技术协议,旨在标准化大型语言模型(LLM)与外部工具和服务的交互方式。你可以把 MCP 理解成像是一个 AI 世界的通用翻译官,让 AI 模型能够与各种各样的外部工具“对话”。

为什么需要 MCP?

在 MCP 出现之前,AI 工具调用面临两大痛点:

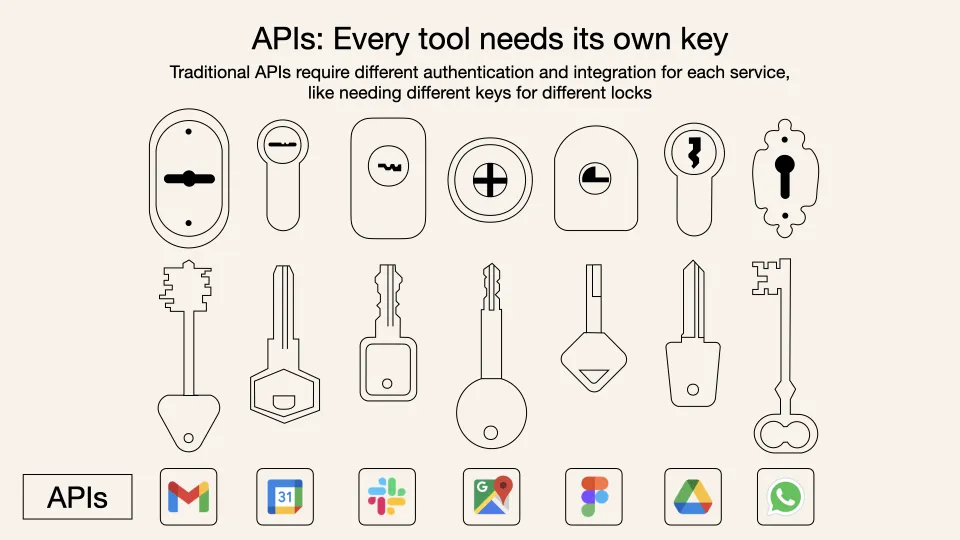

- 接口碎片化:每个 LLM 使用不同的指令格式,每个工具 API 也有独特的数据结构,开发者需要为每个组合编写定制化连接代码。

- 开发低效:这种“一对一翻译”模式成本高昂且难以扩展,就像为每个外国客户雇佣专属翻译。

而 MCP 则采用了一种通用语言格式(JSON - RPC),一次学习就能与所有支持这种协议的工具进行交流。一个通用翻译器,不管什么 LLM,用上它就能使用工具/数据了。

MCP 的工作原理

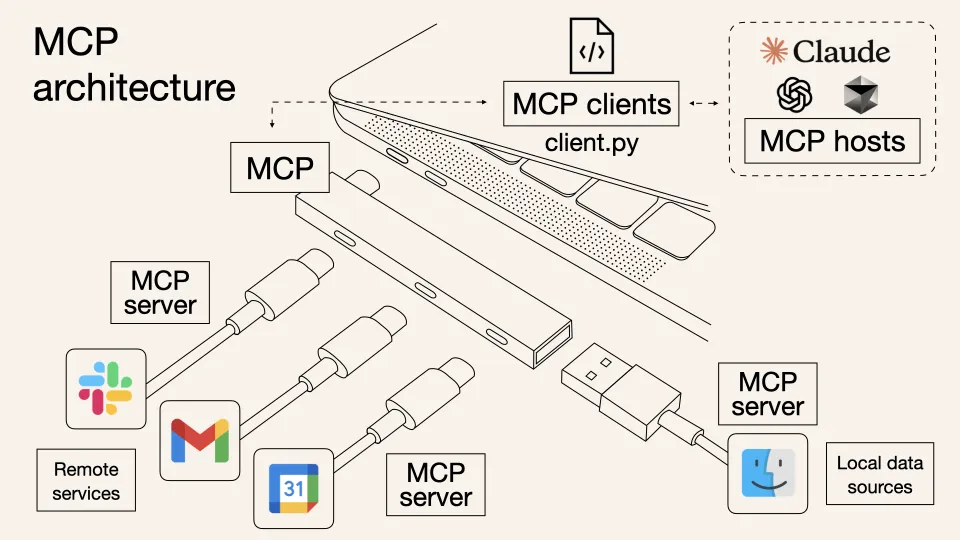

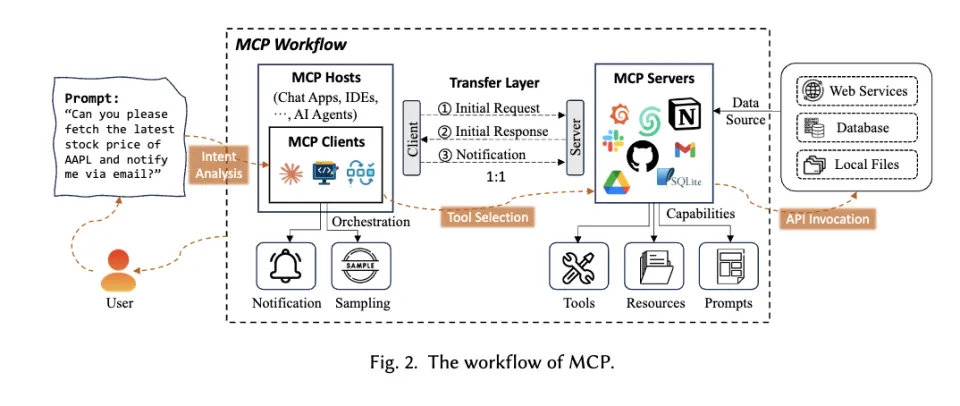

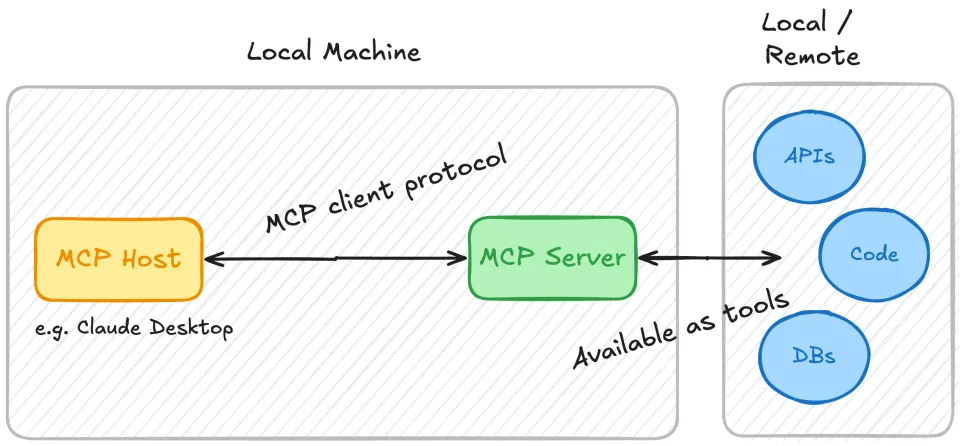

MCP 的技术架构可以简单理解为一个由三个核心部分组成的系统:MCP Host、MCP Client 和 MCP Server。这三部分共同工作,让 AI 模型能够顺畅地与外部世界交流。

MCP 工作流程比喻

要准确理解 MCP 的角色,我们可以将其比作现代企业环境中的一个通信系统:

- 用户:扮演企业高管,负责理解需求并做最终决策。

- 大模型(如 Claude 或 GPT):理解高管指令,规划任务步骤,判断何时使用外部服务,并整合信息提供答案。

- Agent 系统:是真正的私人助理或执行秘书,负责执行任务。

- MCP:像是秘书使用的标准化通信平台,不做决策,只按指示以统一格式与服务提供商交流。

MCP 技术架构核心组件

MCP Host(执行环境):

像是企业的办公环境和基础设施,提供用户与 AI 交互的界面和环境,为 Agent 和 MCP Client 提供运行空间(如 Claude Desktop、Cursor 等 AI 应用)。MCP Client(通信枢纽):

像是秘书使用的标准化通信工具,不参与决策,只按指示以正确格式与服务提供商通信,处理协议、数据格式转换等底层问题。MCP Server(服务终端):

像是各个专业部门或外部服务提供商,负责特定类型的服务(如数据分析、信息检索、内容生成等)。

在MCP出现之前,当秘书需要完成高管的多项任务时,必须切换使用多种通信工具和系统,熟悉各自不同的操作方式。例如,预订会议室需要登录内部系统A,获取财报需要使用系统B,订餐则需要拨打餐厅电话。开发者则需要为每个工具单独编写连接代码,效率低下且难以维护。

在MCP之后,秘书只需使用一个统一的通信平台,就能以相同的方式联系所有部门和服务提供商。开发者也只需实现一次MCP接口,就能让AI系统与所有支持该协议的工具进行交互。

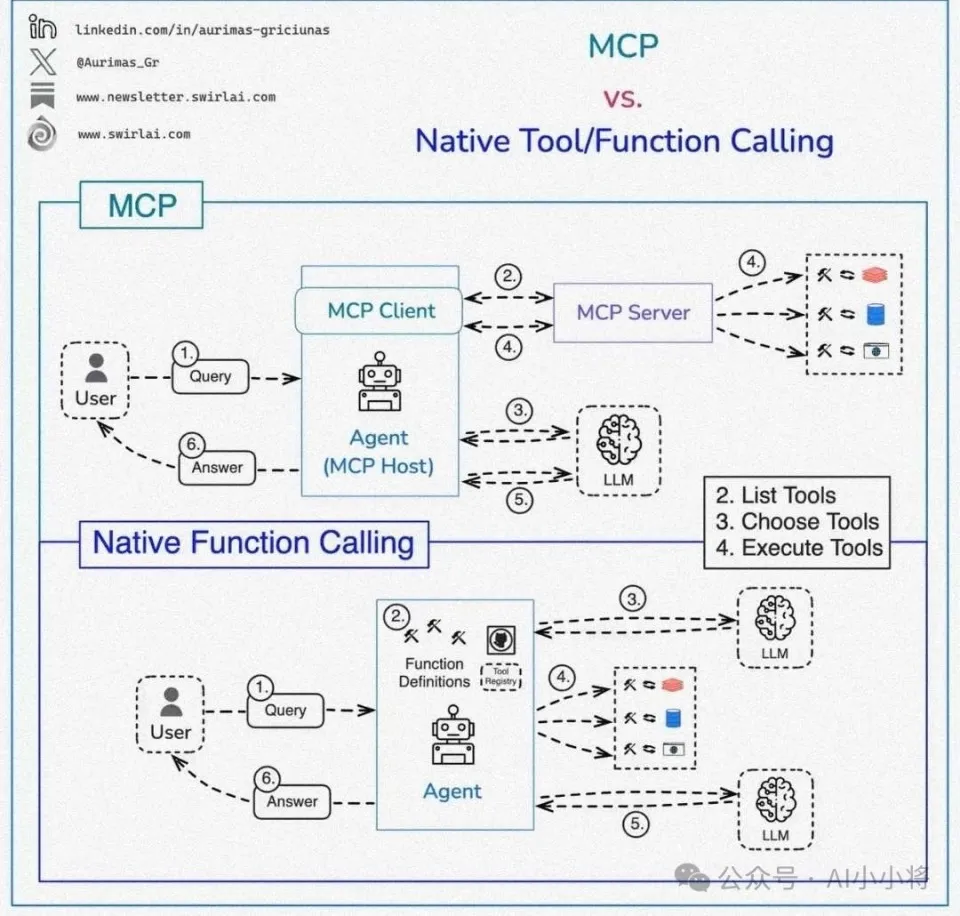

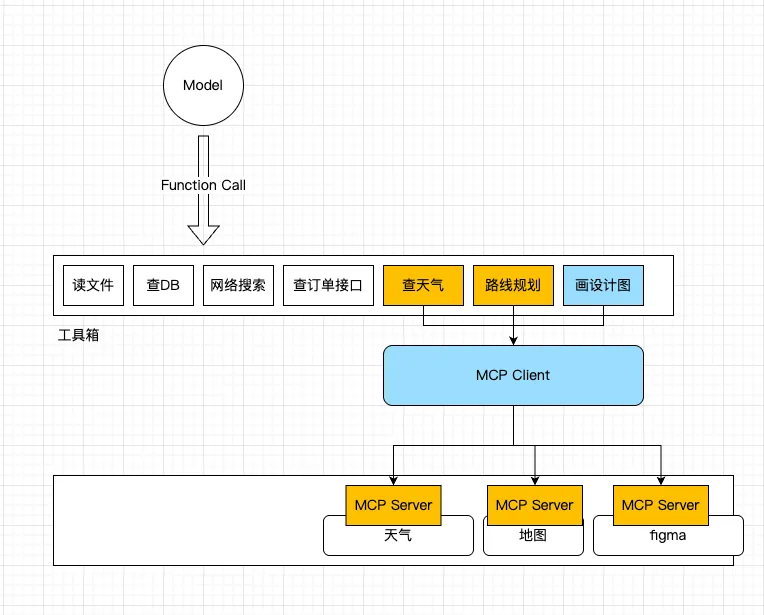

MCP 不是 Function Call 的替代,而是基于 Function Call 的工具箱

很多人认为,MCP 是对传统 Function Call 的一种替代,而实际上,两者并非替代关系,而是紧密合作的关系:

- Function Call:是大型语言模型(LLM)与外部工具或 API 交互的核心机制,是大模型识别何时需要工具、需要啥类型工具的基础能力。

- MCP:是工具分类的箱子,在 Function Call 基础上,联合 Agent 完成复杂任务。

如果把整个工具调用的流程剖析开来,实际是”Function Call + Agent + MCP系统”的组合。

用一句话说清楚:大模型通过 Function Call 表达要调用什么工具,Agent 遵循指令执行调用,MCP 提供统一的工具调用规范。

比喻理解

老板(用户)要喝咖啡,于是,在办公室(MCP Host)里,办公室主任(大模型)吩咐秘书(Agent)去买一杯美式(Function Call)。秘书(Agent)查了一下供应商名册,发现美式咖啡的供应商已接入了美团或公司统一采购系统(实现了MCP Server),接着,秘书在采购系统中找到供应商(MCP Client)一键下单。

在过去没有MCP时,大模型下发Function Call,Agent去执行翻译,直接连接到API去调用工具。因此,你得为每个API单独设置对应的调用模式,去单独定义工具列表和调用模式,这样Agent才知道怎么去翻译。而有了MCP后,只是很多API都可以直接通过供应商MCP Client一键下单了,Agent省力了。但大模型的Function Call没有任何变化。还是{tool: “买加啡”, “type”: “美式”}这个形式。

不过在过去,有人会把这一整套Function Call+ Agent +API的模式叫做一个Function Calling,所以会引起混淆。

通过区分Function Call和MCP,我们可以清晰地看出,MCP并不负责决定使用哪个工具,也不进行任务规划或理解用户意图。这些是Agent层面的工作。MCP只是提供了一个统一的工具接口,成为了产业内认可的工具调用标准协议。

MCP 的开发难题与市场乱局

一宗罪:开发的难题

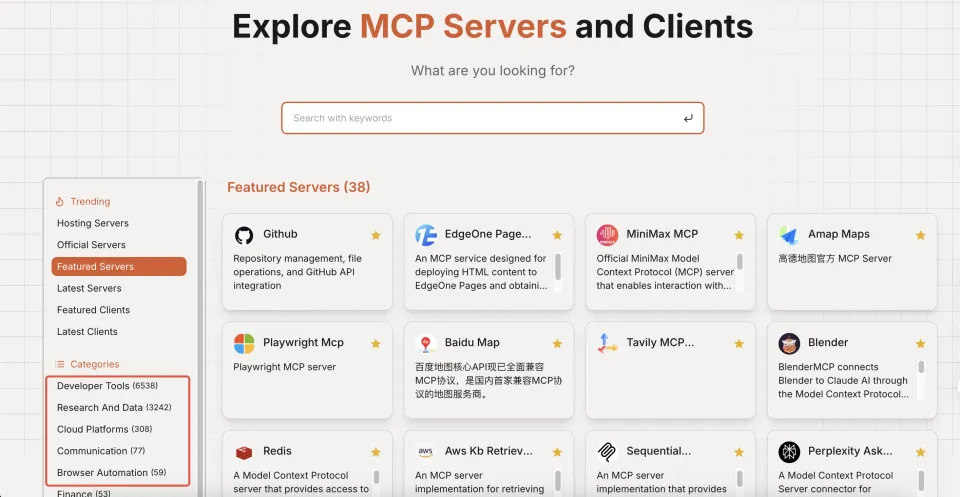

今年 2 月以来,AI 开发社区掀起“MCP 淘金热”。在没有官方应用商店的情况下,短短三个月就有数千个工具自发接入 MCP 协议。

这种野蛮生长让 MCP 迅速成为行业焦点,但也暴露了理想与现实的鸿沟——开发者最初将 MCP 视为“万能钥匙”,实际使用后发现它更像是“专业扳手”,在某些场景下表现出色,在其他场合却显得水土不服。

在MCP的所有参与者中,可以分为本地客户端应用、云端客户端应用和MCP服务端开发者。本地应用就是类似本地的AI助手,云端客户端则是类似于ChatGPT的网页版,而MCP服务器开发者,则是工具的真正供给方。他们需要把自由的API重新做一遍符合MCP规则的包装盒接入。

在MCP刚刚上线的时间内,最开心的是本地客户端应用,而云端客户端应用和MCP服务器开发者就不太舒服了。

要理解这一点,得回到MCP的缘起。

MCP的起源始于Anthropic的Claude Desktop应用,它最初是为了调用本地文件和功能而设计的接口协议,深深植根于客户端的需求土壤中

不同参与者的体验差异

- 本地客户端应用:如 Cursor 和 Claude Desktop,利用 MCP 让用户动态添加工具,解决了与本地环境和外部工具无缝交互的痛点,降低整合成本,对小型团队和个人开发者更友好。

- 云端客户端应用和 MCP 服务端开发者:

MCP 早期对云端服务器采用双链接机制(SSE 长链接 + HTTP 短链接),对大型企业服务提供商而言,实现 MCP 接口增加维护成本,且多服务器架构下跨机器寻址复杂,实施难度大。

云端 AI Agent 通常运行在无状态服务中,使用 MCP Client 时需临时创建和关闭 SSE 链接,复杂度增加、性能下降,且多使用预设工具集,未发挥 MCP 动态工具发现的灵活性。

这种方法对用户及时反馈和中途干预来讲效果很好,这种需要服务器处理的环境中创造了一系列工程挑战。

Kongjie认为,”云端本身的数据交互模式,导致虽然MCP希望能达成工具的自由使用,但实际上用不上。还是必须用非常规范的流程去调用特定的写死的工具,丧失了灵活性的初衷。”

MCP团队的改进:MCP 团队在 3 月 26 日更新协议,使用 streamable HTTP transport 替代原 SSE transport,这样一来,新的协议既支持仅需要单次调用工具请求的无状态服务场景,也兼容了原来通过http + SSE 双链接才能满足的实时推送的诉求。

这说明,当下的一些MCP的问题,源于其最初目的的限制,但并非不可解。

二宗罪:市场的乱局

另一个MCP面对的问题可能就比较普遍了:现在市面上的MCP可用性太低。

当前MCP市场正经历着典型的技术炒作周期。就像当年App Store刚上线时的混乱景象,如今数千个MCP工具中,真正具备实用价值的不足二成。腾讯开发者victorhuang的观察一针见血:“很多MCP,实际上都没有真的做MCP。”

- 实用价值低:数千个 MCP 工具中,真正具备实用价值的不足二成,80% 的 MCP 服务器存在配置错误或无法使用的问题,多数工具是简单封装,市场需求低。

- 缺乏评价体系:Agent 无法依靠可靠指标选择工具,重名或描述相似的工具多,只能反复尝试,浪费资源、降低效率。

- 成功案例的反路径:如 Manus 未采用 MCP 而选择内建应用,Cursor 内置常用开发功能,外部 MCP 工具使用率低。

但MCP市场当前的混乱状态并非失败的标志,而是任何新兴技术生态系统必经的成长阶段。

从历史经验来看,这种初期的过度膨胀往往会通过市场自然选择机制逐渐收敛,留下真正有价值的部分。就像互联网泡沫之后留下了改变世界的电子商务和社交媒体一样,MCP热潮过后可能会形成一个更加精简但更有实质价值的工具生态系统。

这个过程中,至少Anthropic团队也能从善如流,像victorhuang建议的那样“在协议规范上,要求接入协议的服务能保证参数和工具的质量。”这样才能让MCP的生态变得真正“可用”。

MCP 很好,但它不是万灵药

当前对 MCP 的批评存在认知错位:人们期待一个通信协议能完成智能系统的全部工作,这就像指责 USB 接口不能自动修图。MCP 本质是“工具插座”的标准规范,只确保插头插入,不决定用什么电器、怎么用。

Agent 调用工具的效果受工具选择、任务规划、上下文理解等能力制约,这些都不在 MCP 职责范围内。MCP 只承诺提供统一接口,不承诺工具的选择和组合方式。

在技术演进的长河中,我们总是倾向于寻找一劳永逸的解决方案,一种可以解决所有问题的银弹。但如同软件工程中著名的”没有银弹”论断,AI工具调用领域同样不存在万能的解决方案。一个真正强大的AI系统需要多个精心设计的组件协同工作:大语言模型提供基础理解和生成能力,Agent框架负责任务规划和执行逻辑,而MCP则专注于提供统一的工具调用接口。

它展示了良好的协议设计哲学——关注一个问题并解决好它,而非尝试解决所有问题。正是这种克制,使得MCP能够在客户端工具集成领域取得实质性进展。

各大企业对 MCP 的拥抱与区别

- 百度:从 C 端切入,“心响”(Kokone)利用 MCP 整合 AI 模型和外部工具,面向手机端(仅安卓),意图打入日常场景。

- 字节跳动:扣子空间集成超 60 款 MCP 扩展插件,入口为网页端,推出支持 MCP 的 AI 原生 IDE——Trae,瞄准工作和生产力场景。

- 阿里:在支付宝等产品中集成 MCP,4 月 29 日开源 Qwen3 系列模型支持 MCP,增强 Agent 能力。

- 腾讯:腾讯云发布 AI 开发套件支持 MCP 插件托管,知识引擎支持调用 MCP 插件,代码助手 CodeBuddy 兼容 MCP 生态,腾讯地图、云存储发布 MCP Server。

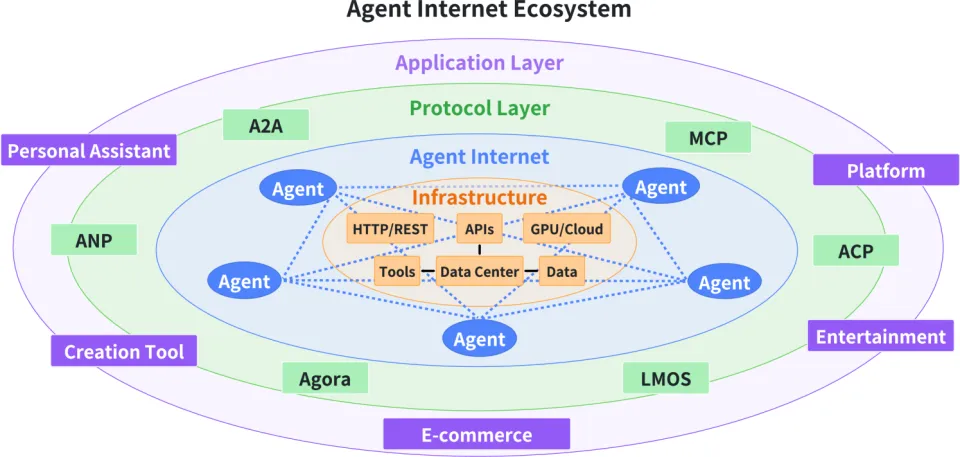

但正如编程范式从汇编语言进化到面向对象一样,AI工具使用也可能从直接操作单一工具进化到与专业化Agent的协作。

在这种新范式下,MCP可能只是底层基础设施的一部分,而不是用户或开发者直接面对的界面。更全面的方案可能需要结合像Agent to Agents(A2A)这样的架构,通过抽象层次提高任务规划和工具选择的效率。

未来展望

AI 工具使用可能从直接操作单一工具进化到与专业化 Agent 协作,MCP 可能只是底层基础设施的一部分,更全面的方案需结合 Agent to Agents(A2A)等架构。当我们将 MCP 放回“协议”的本位,才能看清其推动行业标准化的真实力量——这或许才是技术演进中最珍贵的“祛魅时刻”。